Vertex AI es una plataforma unificada de aprendizaje automático (AA) de Google Cloud que permite entrenar, implementar y personalizar modelos de AA y aplicaciones de IA, incluyendo modelos de lenguaje grandes (LLM), con herramientas para la ingeniería de datos, ciencia de datos y flujos de trabajo de ingeniería de AA.

Eso hace relevante que la Google anunciara, en su evento anual Next ‘25, que Gemini 2.5 Pro, su modelo capaz de realizar análisis profundos de datos, extraer información clave de documentos densos como contratos legales o historiales médicos, ya está en Vertex AI en public preview.

Google también anunció que Gemini 2.5 Flash llegará a Vertex AI para las organizaciones que necesitan priorizar velocidad, baja latencia y eficiencia en costos. Gemini 2.5 Flash, asegura Google, es el motor ideal para agentes virtuales con gran capacidad de respuesta y herramientas de resumen en tiempo real donde la eficiencia a escala es clave.

Google Cloud quiere ser reconocida como la única empresa que ofrece modelos en todas las modalidades de formato: imagen, voz, música y video. Por eso sus modelos están obligados a seguir avanzando permanentemente.

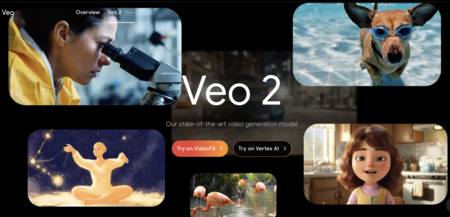

Es así que Imagen 3 ahora tiene capacidades mejoradas de generación/relleno de imágenes; Chirp 3 crea voces personalizada a partir de 10 segundos de entrada de audio; y Lyria, su modelo de texto a música enterprise-ready, transforma indicaciones de texto en clips musicales de 30 segundos. Ah, y no es posible olvidar a Veo 2, que tiene nuevas capacidades de generación y edición de video.

“La oportunidad que presenta la IA no se parece a nada que hayamos presenciado antes. Tiene el poder de mejorar vidas, aumentar la productividad y reimaginar los procesos a una escala antes inimaginable. Google ha estado incorporando el aprendizaje automático a nuestros productos durante más de 20 años, y nuestra inversión en IA está profundamente arraigada en nuestra misión principal: organizar la información del mundo y hacerla universalmente accesible y útil. Con Google Cloud, extendemos esta misión, viendo la IA como el catalizador más potente para ayudar a nuestros clientes, desarrolladores y socios a avanzar en su misión”.--Thomas Kurian, CEO de Google Cloud.

Una red global de próxima generación

Google también anunció que su red privada global, Cloud Wide Area Network, o WAN, ahora está disponible para empresas de todo el mundo.

La red global de Google proporciona un rendimiento hasta un 40 por ciento más rápido en comparación con la internet pública. Abarca más de 200 países y territorios, ofrece una latencia casi nula para servicios como Gmail, Google Fotos y la búsqueda de Google y se utiliza para entrenar a Gemini, el modelo de IA más avanzado de Google y con el que más de 4 millones de desarrolladores ya trabajan.

La TPU de séptima generación, Ironwood, llegará a finales de este año. Es el chip más potente que jamás se haya construido en Google y permitirá el desarrollo de los próximos modelos de IA generativa.

Durante más de una década, las TPU han impulsado el entrenamiento de IA más exigente de Google. Ironwood es, dice Google, el acelerador de IA personalizado más eficaz y escalable hasta la fecha, y el primero diseñado específicamente para la inferencia.

Ironwood es uno de varios componentes nuevos en la arquitectura Google Cloud AI Hypercomputer y en comparación con la primera TPU disponible públicamente, Google dice que logra un rendimiento 3.600 veces mejor.

Según reveló la empresa, el uso de Vertex AI ha experimentado “un crecimiento explosivo” -se multiplicó por 20 el año pasado-, lo que ha dado como resultado miles de aplicaciones de IA creadas por los clientes de Google.