Hasta hace poco, hablarle al celular y esperar que entendiera lo que queríamos seguía siendo, en muchos casos, una experiencia frustrante o limitada. Pero la irrupción de la inteligencia artificial ha cambiado por completo este panorama haciendo posible conseguir respuestas con solamente preguntarle a tu móvil, incluso si es necesario que "vea" tu entorno para hacerlo.

Una capacidad que pudimos comprobar en Xataka Colombia durante una presentación especial de Samsung y Google, compañías que han trabajado juntas para llevar las últimas y más avanzadas innovaciones de IA a los teléfonos.

@jimmypepitech ¡4 usos que le puedes dar a los “ojos” de Gemini Live en tu celular Samsung Galaxy! 😮 una tecnología que con solo pulsar un botón te permite hablar con la inteligencia artificial, así como mostrarle tu entorno para obtener respuestas basadas en lo que estás mirando 👀 Agradecimiento especial a nuestros amigos de @googleespanol y @samsungcolombia que nos invitaron a una sesión exclusiva para conocer de primera mano estas herramientas 🔥 #samsung #celulares #google #gemini #ai #ia #herramientas #tips #fyp #creatorsearchinsights

♬ sonido original - jimmypepitech

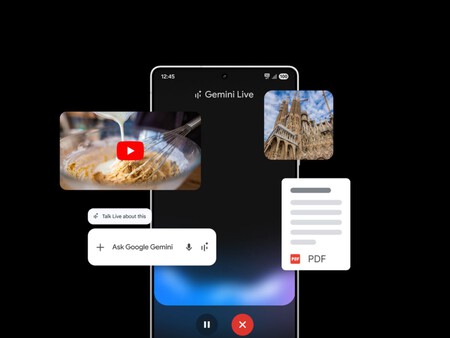

Esta colaboración ahora introduce la integración nativa de Gemini en dispositivos Galaxy y transforma la experiencia de Galaxy AI para que sea más intuitiva a través de capacidades multimodales.

Y así lo pudimos comprobar con Gemini Live, recientemente disponible en español en dispositivos Galaxy S25, que no solo oye lo que dices, sino que puede ver tu entorno para analizarlo junto a tu solicitud y devolverte respuestas en tiempo real.

Lo que puedes hacer con Gemini Live

(Google)

(Google)

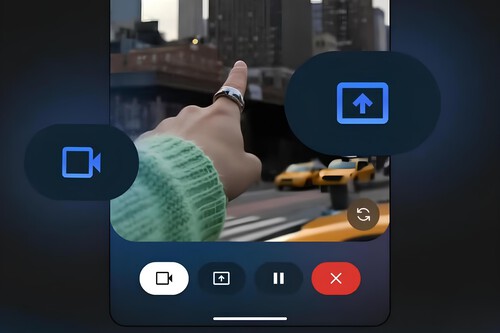

Se trata de una herramienta está pensada para que dejes de escribir largos textos y empieces a conversar. Y así lo pusimos a prueba intentando construir un robot con sus instrucciones.

Para esta tarea solo tuvimos que mantener presionado el botón de encendido para acceder al asistente y pulsar la opción con un ícono de cámara para que la IA pudiera ver y escuchar, algo especialmente útil para encontrar una pieza necesaria o no saltarse pasos en el proceso de armado.

Lo que diferencia a Gemini Live es precisamente esa capacidad multimodal: no se limita a escuchar preguntas, sino que aprovecha la cámara para “ver” lo que tienes delante y darte respuestas adaptadas.

Y esto va más allá que simples indicaciones, porque con solo mostrarle un cartel del próximo Galaxy Unpacked July 2025, para que Gemini Live nos resumiera la información principal del evento, incluyendo fechas, lugar y hora. Mientras que también permitió guardar el resumen como una nota o sumar el evento al calendario.

Pero la integración entre Samsung y Google no se siente como una capa superpuesta, sino como una unión que permite que todo fluya entre apps. Por ejemplo, al utilizar una plataforma como YouTube, la IA fue capaz de analizar el video que estábamos viendo, realizando un resumen del mismo e incluso ofreciendo algunas sugerencias.

En temas educativos, encontramos que esta IA también es funcional para poder resolver problemas matemáticos con solo observarlo de un libro. Además, nos pudo ofrecer una explicación sencilla del ejercicio. Asimismo, es capaz de traducir textos o conversaciones completas al instante.

Capacidades de IA que buscan expandirse

(Google)

(Google)

Pese a que Gemini Live por ahora solo está integrada en la serie Galaxy S25, próximamente llegará a más dispositivos Galaxy, incluidos algunos modelos de la serie A. Esto abre la puerta a que más puedan acceder a este tipo de inteligencia artificial sin tener que cambiar de dispositivo a uno de gama premium.

Lo cierto es que esta IA capaz de entender lo que decimos, lo que mostramos y lo que necesitamos, sin que tengamos que escribir ni una sola palabra, ya se encuentra en fase de expansión y el objetivo es que cada vez llegue a un mayor número de usuarios.

Ver 0 comentarios