El creciente interés de figuras poderosas por influir o supervisar lo que la inteligencia artificial dice sobre política y personajes públicos fue puesto en evidencia recientemente por Andrew Bailey, el fiscal general de Missouri en Estados Unidos.

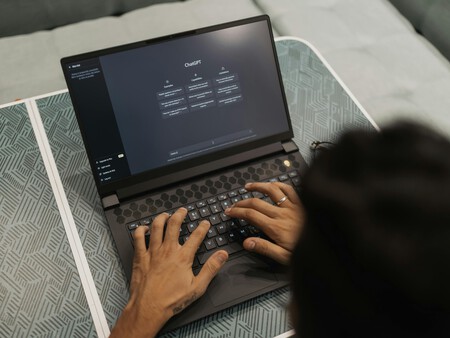

Bailey, del partido republicano, exigió explicaciones a gigantes tecnológicos como Google, Microsoft, OpenAI y Meta sobre cómo sus modelos de IA generan respuestas en temas delicados, tras acusar a varios chatbots de mostrar sesgos en contra del presidente Donald Trump.

Bajo esa premisa, requirió a las empresas que entreguen documentos sobre cualquier política o práctica relacionada con la moderación, bloqueo, o manipulación de resultados en las respuestas de sus modelos, una solicitud tan amplia que abarcaría buena parte de la información interna sobre el entrenamiento y funcionamiento de estos sistemas.

Qué motivó esta investigación

(Pexels)

(Pexels)

El detonante de la investigación fue una publicación en un medio conservador que realizó la misma consulta a seis chatbots, pidiéndoles clasificar a los últimos cinco presidentes estadounidenses “del mejor al peor” específicamente en materia de antisemitismo.

Según el blog, al menos tres de esos chatbots entre ellos Gemini, ChatGPT y Meta AI, situaron a Trump en la última posición, lo que el fiscal interpretó como un indicio de sesgo.

Incluso Microsoft recibió un requerimiento, aunque el propio blog aclaró que Copilot se negó a contestar la pregunta, lo que no evitó que Bailey enviara una carta también a Satya Nadella, su CEO, exigiendo explicaciones.

En sus comunicaciones, Bailey sostiene que estos sistemas están obligados a “extraer hechos de la web mundial y entregarlos al público libres de distorsión o sesgo”.

Intenciones con un tinte político

(Pexels)

(Pexels)

La investigación se produce en un contexto en el que actores políticos empiezan a ver a los modelos de lenguaje no sólo como herramientas tecnológicas, sino como espacios de disputa cultural y política.

En su argumentación, Bailey ha insinuado que el supuesto sesgo en las respuestas debería quitar a las tecnológicas la inmunidad legal que disfrutan como “publicadores neutrales” bajo la Sección 230 de la Ley de Decencia en las Comunicaciones, una interpretación legal que no cuenta con consenso en el ámbito jurídico y que ha sido impulsada en años recientes principalmente desde sectores conservadores.

Aunque este proceso podría no tener consecuencias legales inmediatas, subraya cómo la narrativa sobre la supuesta parcialidad de la IA se ha convertido en un instrumento político.

Se suma además a antecedentes como la investigación bloqueada que el propio Bailey inició contra Media Matters, relacionada con los contenidos que aparecían en X, la red social de Elon Musk, junto a publicidad sensible.

Musk y la polémica con Grok

(Pexels)

(Pexels)

El hombre más rico del mundo se encargó de añadir otra capa a este debate sobre quién influye en las respuestas de la IA.

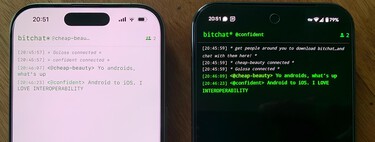

Recientemente se reveló que Grok, el chatbot de xAI integrado en su red social X, consulta activamente las opiniones del propio Musk cuando responde preguntas sobre temas controvertidos como el conflicto entre Israel y Palestina, las políticas migratorias en Estados Unidos o el aborto.

Pruebas publicadas por desarrolladores y periodistas muestran que Grok, al enfrentar consultas complejas, examina las declaraciones públicas de Musk y las utiliza como referencias predominantes en sus respuestas.

Esto ocurre a pesar de que el sistema está instruido para buscar un equilibrio de fuentes y para desconfiar de sesgos en medios de comunicación. De hecho, recientemente fue el centro de la polémica por sus respuestas a favor de Hitler.

Sin embargo, el hecho de que Grok “sepa” que es una creación de una empresa propiedad de Musk parece inducirlo a incorporar las opiniones de su fundador en cuestiones sensibles.

Respuestas de la IA: un terreno en disputa

(Pexels)

(Pexels)

La paradoja es que mientras algunos políticos acusan a empresas tecnológicas de censurar ciertas posiciones, existen modelos que, en lugar de neutralidad, parecen inclinarse hacia los puntos de vista de sus dueños o creadores.

El resultado es un paisaje en el que las respuestas de la IA se convierten en terreno de disputa, tanto para intereses políticos como empresariales.

La investigación de Bailey refleja un amplio interrogante: hasta qué punto es legítimo y seguro que gobiernos, empresas o individuos busquen modelar las respuestas de sistemas de inteligencia artificial que hoy median cada vez más conversaciones sociales, políticas y culturales.

Ver 0 comentarios